Le thème de l'intelligence artificielle a dominé l’actualité en 2023. Au cœur du débat, les questions relatives à l’impact de cette technologie sur l'écosystème de l'information en ligne. Les inquiétudes concernant la manipulation des élections, les conseils erronés sur la santé et l'usurpation d'identité foisonnent, à juste titre, car nous avons commencé à voir des exemples justifiant ces craintes.

Des images générées par IA, décrivant des événements politiques n’ayant jamais eu lieu (ou n'ayant pas encore eu lieu), ont ainsi été déjà diffusées sur internet. Certaines évoquent une explosion au Pentagone, le siège du ministère américain de la Défense. D'autres prétendent montrer l’arrestation de l'ancien président américain Donald Trump ou encore le président français Emmanuel Macron au cœur d’une foule de manifestants.

Des exemples plus anodins tendent à être encore plus convaincants, comme les images du pape François, le chef de l'Église catholique, vêtue d’une doudoune blanche.

En réalité, l'utilisation de photos et de vidéos manipulées ou fabriquées pour diffuser de fausses nouvelles n'a rien de nouveau. D'une certaine manière, les méthodes de détection de ce type de contenus trompeurs restent les mêmes.

Cependant, les technologies de l'IA s’améliorent rapidement et posent des défis uniques dans la lutte contre la désinformation. Nous sommes de plus en plus en contact avec des contenus susceptibles d'avoir été manipulés ou générés par intelligence artificielle, d’où la nécessité d’apprendre à les repérer.

Voici quelques éléments à observer avec attention face à des images en ligne.

Indices dans la photo ou dans la vidéo

Les outils qui utilisent l'IA pour générer ou manipuler des contenus fonctionnent de différentes manières et laissent différents indices dans ces contenus. Au fur et à mesure que la technologie s'améliore, le nombre d'erreurs commises diminue. Les indices décrits ci-dessous sont des éléments qui peuvent être valables au moment où vous lisez cet article, mais qui ne seront certainement pas intemporels.

Vérifier la présence d'un filigrane ou d'une clause de non-responsabilité

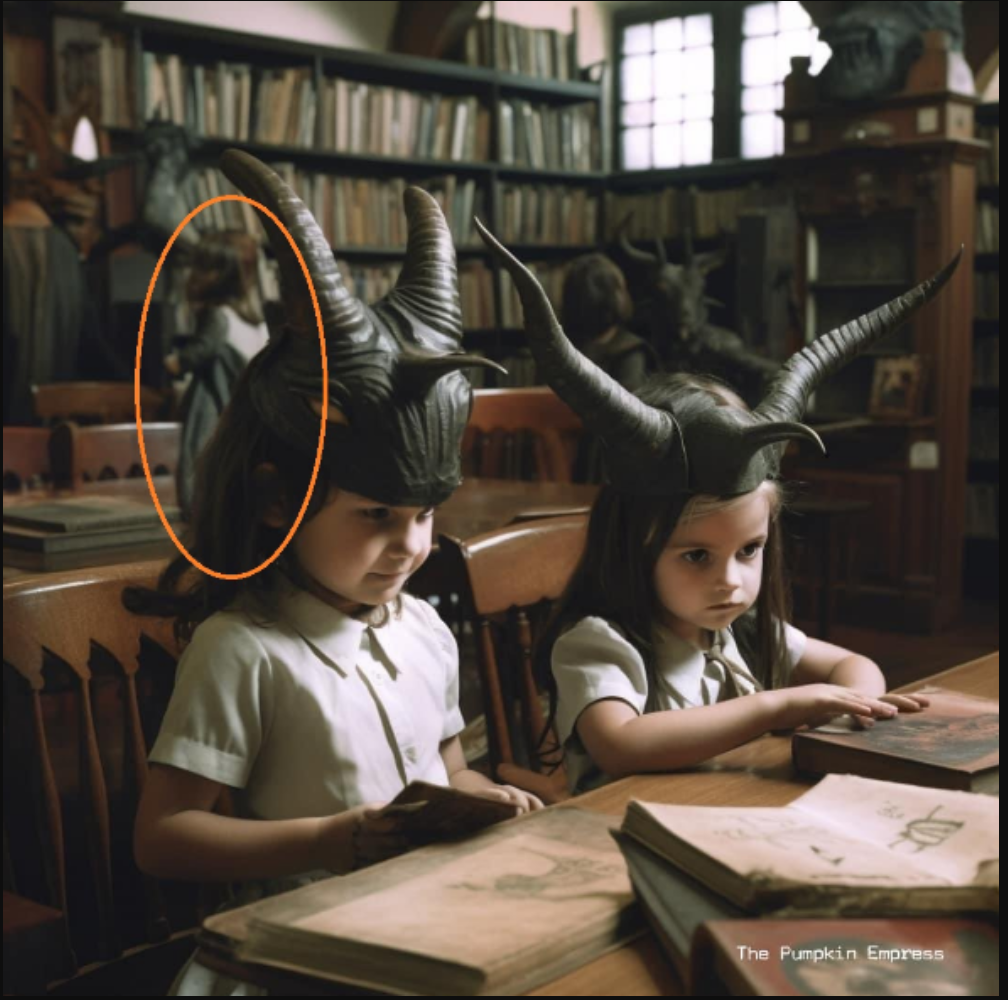

Lorsqu'il s'agit d'images générées par IA, le diable se cache toujours dans les détails. En mai 2023, une série de photos a circulé sur les réseaux sociaux en Afrique du Sud, montrant des enfants dans une bibliothèque, entourés d'images et de personnages qu’on pourrait qualifier de sataniques. Sur ces illustrations, les enfants sont assis à même le sol, dans une bibliothèque, autour d'un pentagramme, l'étoile à cinq branches souvent associée aux croyances aux sciences occultes.

Des utilisateurs n’ayant pas réalisé que ces images avaient été générées par IA avaient exprimé leur indignation. Cet exemple montre à quel point il est facile de créer des photos assez réalistes à première vue. Il montre aussi comment des internautes peuvent être facilement induits en erreur, même si ce n'était pas l'intention de l’auteur(e) de ces images. Celles de ces enfants à la bibliothèque ont été signées par The Pumpkin Empress, littéralement, « L’impératrice de la citrouille », qui y a intégré un filigrane numérique mentionnant le nom de son compte. Mais le filigrane a été supprimé par d’autres internautes au fur et à mesure que ces images ont été reprises.

Un filigrane est un dessin ajouté à un objet pour faire valoir son authenticité ou identifier son origine. Ainsi, le filigrane numérique est une donnée intégrée à la propriété intellectuelle numérique pour identifier l’auteur ou le propriétaire d’une création (image, vidéo, etc.). Les billets de banque, par exemple, comportent des filigranes comme signe d'authenticité. De grands filigranes visibles sont également placés sur les images qui sont la propriété de banques d’images ou de sites de photos d'archives afin d'empêcher leur utilisation avant l'achat.

Une recherche rapide sur Google avec les termes The Pumpkin Empress renvoie à des comptes Instagram, Twitter et Facebook contenant des images similaires générées par IA. Sur la base de nos observations, nous pensons que ces images ont été publiées par une personne ayant un penchant pour la création artistique par intelligence artificielle d’images relatives à l’univers démoniaque, plutôt que par une personne essayant de documenter un phénomène réel. Il s'agit là du premier indice majeur.

Parfois, les outils d'intelligence artificielle laissent des erreurs subtiles dans les contenus produits, mais il arrive aussi qu'il y ait du texte ou un filigrane révélant qu’il ne s’agit pas de photos réelles. Ces filigranes peuvent être faciles à supprimer par la suite, et il est peu probable qu’une personne voulant vous induire en erreur mette un filigrane flagrant (ou visible à première vue) sur une image, cependant, il est toujours important de commencer par rechercher cet indice.

Pour les images

Jean le Roux est chercheur associé au Digital Forensic Research Lab (DFRLab), un laboratoire de recherche dans le domaine de l’informatique judiciaire. Il étudie les technologies telles que l'IA et leur lien avec la désinformation. Il a expliqué à Africa Check qu'en raison de la manière dont les algorithmes fonctionnent dans les générateurs d'images actuels alimentés par l'IA, ces outils peinent à recréer parfaitement certaines caractéristiques.

Un exemple classique est celui des mains. Au départ, ces outils avaient beaucoup de mal avec les mains des personnages créés, aux doits déformés, manquants ou plus nombreux que d’ordinaire. Toutefois, ce signe révélateur est rapidement devenu moins fréquent au fur et à mesure que les générateurs se sont améliorés.

Les outils d'IA ont le même problème avec les dents qu'avec les mains. Il convient donc d'examiner attentivement les autres parties du corps humain comme les visages. Le Roux a par ailleurs suggéré de rechercher des yeux mal assortis, des traits de visage ou des membres manquants, déformés, fondus ou même dédoublés.

Cependant, certains indices peuvent aussi se résumer à une impression de « décalage » ou d'« étrangeté » au premier coup d'œil, semblable à l'effet de la « Vallée de l’étrange ». Cette expression, en anglais « Uncanny valley », désigne le sentiment de malaise que suscite un objet, un robot, par exemple, ressemblant beaucoup à un être humain sans être tout à fait convaincant. D’autres indices figurent dans un guide mis en ligne le 23 mars 2023 par AFP Factuel, le service de vérification de faits de l’Agence France-Presse (AFP) : une peau paraissant trop lisse ou polie, ou ayant un éclat plastique, peut également être un signe qu'une image a été générée par l'IA.

D’après le même guide d’AFP Factuel, les accessoires peuvent, par ailleurs, être des signaux d'alarme. Faites attention aux lunettes ou aux bijoux qui donnent l’impression d’avoir été fondus dans le visage de la personne. Les modèles d'IA ont souvent du mal à rendre les accessoires symétriques et peuvent montrer des personnes portant des boucles d'oreilles mal ajustées ou des lunettes aux montures bizarres.

Outre les silhouettes humaines, il peut être utile d'examiner les détails des textes, des panneaux ou de l'arrière-plan de l'image. Jean Le Roux a souligné que les outils de création d’IA peinaient sur des motifs répétitifs, comme les boutons d'un téléphone ou les coutures d'un tissu.

Toutefois, il pourrait être plus difficile de repérer des paysages générés par l'IA que des images d'êtres humains, comme l'a expliqué l'expert en IA Henry Ajder au média allemand Deutsche Welle (La Voix de l’Allemagne, en français) dans un article (en anglais) mis en ligne le 9 avril 2023. Si vous regardez un paysage, le mieux est peut-être de comparer les détails de l'image avec des photos dont vous pouvez confirmer le lieu de prise.

En résumé, portez une attention particulière aux éléments suivants :

- Accessoires (boucles d'oreilles, lunettes).

- Arrière-plans (formes ou personnes bizarres ou fondantes).

- Parties du corps (doigts manquants, parties du corps supplémentaires).

- Motifs (objets ou éléments répétitifs comme les boutons d'un appareil, les motifs sur un tissu ou les dents d'une personne).

- Textures (reflets de la peau ou textures qui se fondent, se mélangent ou se répètent de manière non naturelle).

- Éclairage et ombres.

Pour les vidéos

Les deepfakes sont des vidéos qui ont été manipulées à l'aide d'outils permettant de combiner ou de générer des visages et des corps humains. Ces manipulations audiovisuelles vont des véritables deepfakes, qui sont beaucoup plus réalistes et qui nécessitent des outils spécialisés, aux cheap fakes, des vidéos amateurs manipulées qui sont aussi simples à réaliser que la modification du son d'un clip vidéo pour masquer certains mots d'un discours afin d’en changer le sens. Dans ce cas, il suffit de trouver la vidéo originale pour réfuter le contenu manipulé.

Bien que les deepfakes réalistes puissent être difficiles à détecter, surtout lorsque l'on n’a pas de compétences spécialisées, il existe souvent des indices que l'on peut repérer en fonction de ce qui a été fait, qu'il s'agisse de synchronisation labiale (le fait de faire correspondre les paroles de la version modifiée de l’audio avec le mouvement des lèvres), de superposition d'un visage différent sur un corps ou de modification de la vitesse de la vidéo.

Jean Le Roux, de DFRLab, a confié à Africa Check qu'il y a généralement des indices dans l'audio, comme la voix ou l'accent, qui sonnent « faux ». Il peut y avoir des problèmes avec les mouvements du corps, en particulier lorsque des logiciels bon marché ou gratuits sont utilisés. Parfois, des images fixes sont utilisées avec des bouches ou des têtes animées et superposées, ce qui signifie qu'il y a une absence suspecte de mouvement dans le reste du corps. Un effet général du type de la vallée de l’étrange est également un indice : il peut se traduire par des détails subtils tels que l'éclairage, la couleur de la peau ou les ombres qui semblent peu naturels.

Ces indices sont tous identifiables dans une vidéo qui a circulé sur les réseaux sociaux en mars 2023 et dans laquelle apparaît le président sud-africain Cyril Ramaphosa. Dans cette vidéo, Cyril Ramaphosa, qui a l’air de s'adresser à la Nation, présente un plan gouvernemental visant à résoudre la crise énergétique actuelle en Afrique du Sud en démolissant le monument Voortrekker et le stade de rugby Loftus Versfeld, tous deux situés à Pretoria, la capitale, pour faire place à de nouveaux « générateurs diesel à grande échelle ». Mais, sur la vidéo, le président a l'air immobile, son visage et son corps bougent à peine pendant qu'il parle. Sa voix et son accent ont semblé étranges à l’écoute pour la plupart des Sud-Africains et les mouvements de ses lèvres ne correspondaient pas parfaitement aux mots entendus.

- Observez les détails du visage. Accordez une attention particulière aux mouvements de la bouche et du corps, aux yeux (bougent-ils ou clignent-ils ?), et aux détails de la peau.

- Écoutez attentivement la voix. Semble-t-elle robotique ou peu naturelle ? L'accent correspond-il à d'autres enregistrements de la personne qui parle ? La voix est-elle alignée sur les mouvements de la bouche ? La voix semble-t-elle avoir été ralentie ou accélérée ?

- Examinez l'arrière-plan. Correspond-il à l'éclairage et à l'aspect général du corps et du visage ? A-t-il un sens dans le contexte de la vidéo ?

Le contexte est essentiel

Au fur et à mesure que la technologie progresse, il devient plus difficile de détecter les images ou les vidéos truquées des vraies. Il faudrait donc s'appuyer sur d'autres outils pour séparer la réalité de la fiction. Heureusement, ces outils d’intelligence artificielle impliquent de revenir à l'essentiel en examinant la manière dont une image ou une vidéo s'inscrit dans le contexte de manière plus générale.

Qu'il s'agisse d'un deepfake convaincant et sophistiqué ou d'un cheap fake rapide, les principes de base de la détection de la désinformation par le contexte s'appliquent toujours.

1. Pensez au message global ou au sentiment véhiculé. Selon Jean Le Roux, l'examen du contexte revient à se poser la question suivante : « Qu'est-ce que ce site web essaie de me dire ? Qu'est-ce que ces comptes de réseaux sociaux essaient de véhiculer comme information ? ».

Essayez d'identifier les émotions que le contenu tente de susciter. Semble-t-il vouloir vous mettre en colère, vous indigner ou vous dégoûter ? La réponse à ces questions peut être un signal d'alarme.

2. Que disent les autres ? Il est souvent utile d'aller au-delà de votre première réaction pour voir ce que d'autres personnes pensent. Lisez les commentaires d'une publication sur les réseaux sociaux, car ils peuvent donner de bons indices, mais regardez aussi ce que disent des sources dignes de confiance. Si l'événement représenté a un impact important (par exemple, le président sud-africain Cyril Ramaphosa en train de démolir un célèbre monument culturel pour faire place à une centrale électrique), il est presque certain qu'il aurait fait l'objet d'une couverture médiatique de la part des principaux organes de presse. Si ce n'est pas le cas, ou si le contenu suspect contredit ce que disent des médias ou des organismes scientifiques fiables, cela peut être un indice qu'il est trompeur.

3. Interrogez les moteurs de recherche : Google, Bing ou DuckDuckGo… Si vous soupçonnez que quelque chose n'est pas tout à fait exact (ou même si vous ne le soupçonnez pas), voyez quelles sont les autres informations disponibles en ligne à ce sujet. Si une vidéo décrit un événement, par exemple l'arrestation de l’ex-président américain Donald Trump, effectuez la recherche avec votre logiciel habituel.

Si vous pensez qu'une vidéo a pu être modifiée pour en changer le sens, essayez de trouver la vidéo originale. Cela peut être possible en recherchant le nom de l'événement ou certains mots s'y rapportant (par exemple, « Ramaphosa message à la Nation avril 2023 »).

Il se peut qu'une recherche inversée donne de meilleurs résultats. Bien qu'elle soit généralement utilisée pour les images, il existe des moyens simples d'effectuer une recherche inversée sur les vidéos. Des outils comme InVID le font pour vous, en utilisant des captures d'écran de la vidéo.

4. Comparez avec des images ou des vidéos réelles. De la même manière que vous utilisez des indices visuels pour déterminer où une photo a été prise, essayez d'identifier des détails que vous pouvez comparer à des informations précises. Si une image est censée représenter une personne ou un lieu réel, les détails tels que les traits du visage, les coupes de cheveux, les paysages et autres doivent correspondre à la réalité.

Article traduit de l’anglais par Azil Momar Lô. Édité par Valdez Onanina et Coumba Sylla.

Le texte original a été publié le 10 juillet 2023 sur notre site anglophone.

en tant que fack-cheker de…

en tant que fack-cheker de formation j'ai vraiment beaucoup appris en lisant cet article bien que l'affaire de IA a beaucoup amméné trop des confusions dans le domaine de verification.

Ajouter un commentaire

Ajouter un commentaire